El Apple Glass, del que se rumorea mucho, podría simplemente obtener información de otros modelos para mapear correctamente un ecosistema, con pantallas montadas en la cabeza que capturan detalles en una escena y la comparten para una mejor experiencia de realidad aumentada.

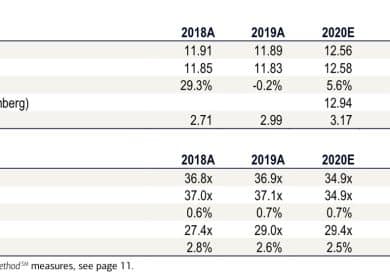

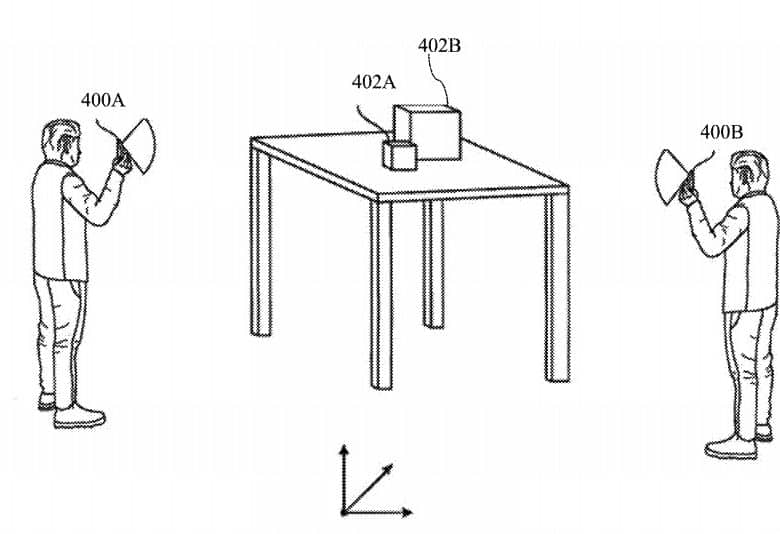

La realidad aumentada depende de tener una medida exacta de la geometría en un entorno, con equipos de imágenes que realizan el trabajo mientras las cámaras se mueven por un espacio. Para un solo auricular, esto puede ser un proceso bastante lento, pero hacer la tarea exacta usando múltiples dispositivos puede ser igualmente valioso y generar sus propios problemas.

Para empezar, si varios dispositivos AR están comprobando un entorno de forma independiente, es posible que la geometría de los mapas que cada uno cree no sea correcta automáticamente. Dos personas que miran una región basándose principalmente en datos recopilados de forma independiente pueden ver ligeramente objetos digitales colocados de diferentes maneras debido a las variaciones del mapa.

En una patente otorgada a Apple el martes por el entorno de la Oficina de Marcas y Patentes de EE. UU. titulada “Localización y mapeo simultáneos de muchas personas (SLAM)”, Apple sugiere que el uso de múltiples productos podría ser útil al compartir información de mapeo, lo que puede hacer un más mapa exacto para todos los usuarios finales.

La precisión se puede mejorar en un puñado de enfoques, tales como unidades múltiples que pueden ejecutar una tecnología de mapa original de una ubicación a un ritmo más rápido que una máquina individual, o que un sistema en particular podría capturar áreas por segundo. solo uno no podrá ver o se saltará por completo. Tener puntos de conocimiento de copia para el mismo lugar mapeado también es valioso, ya que puede usarse para corregir cualquier falla en un mapa producido.

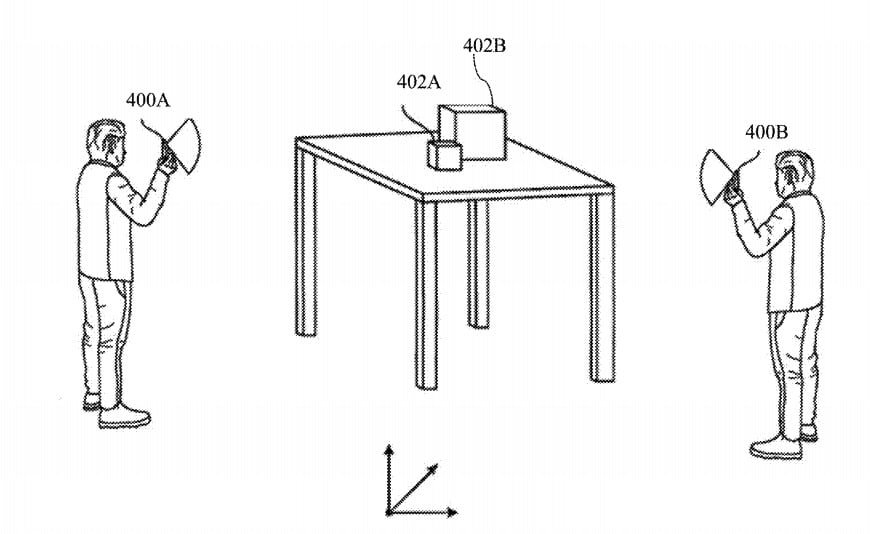

Al generar un mapa más preciso, esto puede hacer posible una mejor ubicación de marcadores virtuales en una tierra, de modo que los objetos electrónicos y las escenas se puedan ver en el lugar exacto del globo real desde muchos auriculares o dispositivos.

En la descripción de Apple, los sensores de imágenes en los dispositivos crean fotogramas clave a partir de imágenes en una atmósfera, que se aplican a programas de coordenadas dependientes del producto. Los fotogramas clave pueden incluir datos de imagen, más información y una representación de una pose del dispositivo, entre otros elementos. Cada sistema genera entonces mapas de áreas relativas.

Luego, los fotogramas clave se intercambian en relación con el equipo, se emparejan con los fotogramas clave propios del dispositivo y luego se utilizan en los cálculos para crear más puntos de mapeo. Las coordenadas del lugar de anclaje también se comparten entre los equipos para el posicionamiento de objetos.

La patente aumenta que el proceso podría hacer el trabajo de forma descentralizada, con equipos que se comunican directamente en lugar de depender de un servidor intermediario para compartir los detalles. En situaciones en las que los datos de posicionamiento se comparten entre los compradores en una aplicación, como los juegos, el intercambio normalmente utiliza un servidor central para distribuir la información que involucra a los jugadores, pero Apple en su lugar presenta un método mucho más publicitario de interacción directa para una sesión de mapeo AR.

Los puntos de vista distintivos pueden permitir que un producto en particular comparta información sobre un artículo que otro no puede ver.

La patente enumera a sus inventores como Abdelhamid Dine, Kuen-Han Lin y Oleg Naroditsky. Fue presentado el 2 de mayo de 2019.

Los datos de Apple presentan varios programas de patentes semanalmente, pero si bien las solicitudes de patentes son un indicador de los lugares de interés para los esfuerzos de estudio y mejora de Apple, no garantizan que los principios aparecerán en un producto o servicio futuro.

Aunque la idea de SLAM se puede ejecutar en dispositivos móviles, como iPhones que usan aplicaciones ARKit, es más probable que los compradores experimenten este tipo de idea en Apple Glass, las gafas inteligentes de Apple con capacidades de realidad aumentada que se rumorea desde hace mucho tiempo.

Las solicitudes de patentes de 2016 indican que Apple solo quería tomar ventaja del posicionamiento AR en los programas, con una versión basada principalmente en Iphone utilizada para “mapas de realidad aumentada” que superpondrían un mapa digital y detalles en una cámara de globo serio. Una presentación vinculada de 2017 indicó que se podría usar un sistema AR para ubicar objetos cercanos a un usuario, que nuevamente podría mostrar más detalles en una pantalla y obtener más detalles de otra manera.